인공지능 모델을 만들고 싶은데, 코드가 너무 복잡하고 어렵다고 느끼신 적이 있으신가요? 혹은, GPT-3처럼 거대하고 강력한 모델을 만들고 싶은데, GPU가 부족하거나 복잡한 병렬화 기법을 적용해야 한다고 생각하시나요? 그렇다면, 이 글을 읽고 gigaGPT라는 프로젝트를 알아보세요.

gigaGPT는 565줄의 코드로 GPT-3와 같은 크기의 인공지능 모델을 학습하고 미세조정할 수 있는 프로젝트입니다. gigaGPT는 Cerebras라는 회사가 만든 것으로, Andrei Karpathy가 만든 nanoGPT라는 간단하고 컴팩트한 코드 베이스를 Cerebras의 하드웨어를 활용하여 확장한 것입니다. gigaGPT는 기본적인 torch.nn 코드로 대규모 학습을 가능하게 하며, 긴 문맥 길이와 다양한 최적화 방법을 지원합니다. gigaGPT를 통해, 당신은 복잡하고 어려운 코드를 걱정하지 않고, GPT-3 수준의 인공지능 모델을 만들고 실험해볼 수 있습니다.

목차

gigaGPT란?

gigaGPT는 GPT-3와 같은 크기의 인공지능 모델을 565줄의 코드로 학습하고 미세조정할 수 있는 프로젝트입니다. gigaGPT는 Cerebras라는 회사가 만든 것으로, Andrei Karpathy가 만든 nanoGPT라는 간단하고 컴팩트한 코드 베이스를 Cerebras의 하드웨어를 활용하여 확장한 것입니다. gigaGPT는 기본적인 torch.nn 코드로 대규모 학습을 가능하게 하며, 긴 문맥 길이와 다양한 최적화 방법을 지원합니다.

GPT-3는 OpenAI가 만든 인공지능 모델로, 1750억 개의 파라미터를 가지고 있습니다. GPT-3는 자연어 처리 분야에서 다양한 작업을 수행할 수 있으며, 텍스트 생성, 질의 응답, 요약, 번역, 대화 등에 뛰어난 성능을 보여줍니다. 하지만, GPT-3는 학습하고 사용하기가 매우 어렵습니다. GPT-3는 GPU 메모리에 들어가지 않기 때문에, 모델을 여러 조각으로 나누고, 여러 GPU에 분산시켜야 합니다. 이를 위해서는 Megatron, DeepSpeed, NeoX, Fairscale, Mosaic Foundry 등의 복잡한 병렬화 프레임워크를 사용해야 합니다. 이러한 프레임워크는 코드의 양과 난이도를 증가시키며, 디버깅과 유지보수를 어렵게 만듭니다. 또한, GPT-3는 OpenAI가 제한적으로만 공개하고 있으며, 자유롭게 학습하고 미세조정하고 실험할 수 없습니다.

gigaGPT는 이러한 문제를 해결하기 위해 만들어졌습니다. gigaGPT는 nanoGPT라는 간단하고 컴팩트한 코드 베이스를 기반으로 합니다. nanoGPT는 Andrei Karpathy가 만든 프로젝트로, 639줄의 코드로 GPT-2 아키텍처를 구현하고, 1억 개의 파라미터를 가진 모델을 학습하고 미세조정할 수 있습니다. nanoGPT는 GPT 모델을 이해하고 수정하고 실험하기에 적합한 코드 베이스입니다. 하지만, nanoGPT는 1억 개 이상의 파라미터를 가진 모델을 학습하기에는 부족합니다. nanoGPT는 GPU 메모리에 제한되어 있으며, 병렬화 기법을 사용하지 않습니다.

gigaGPT는 nanoGPT를 Cerebras의 하드웨어를 활용하여 확장한 것입니다. Cerebras는 CS-1이라는 대형 인공지능 컴퓨터를 만든 회사입니다. CS-1은 Wafer Scale Engine이라는 거대한 칩을 사용합니다. Wafer Scale Engine은 46,225mm2의 면적에 1.2조 개의 트랜지스터와 400,000개의 코어를 가지고 있습니다. Wafer Scale Engine은 18GB의 온칩 메모리와 9PB/s의 메모리 대역폭을 제공합니다. Wafer Scale Engine은 GPU보다 200배 더 큰 메모리와 10,000배 더 빠른 통신 속도를 가지고 있습니다. Wafer Scale Engine은 GPT-3와 같은 크기의 모델을 하나의 칩에 올릴 수 있습니다.

gigaGPT는 Wafer Scale Engine의 큰 메모리와 빠른 계산력을 활용하여, nanoGPT의 코드를 그대로 사용하면서도, GPT-3와 같은 크기의 모델을 학습하고 미세조정할 수 있습니다. gigaGPT는 복잡한 병렬화 기법을 사용하지 않고, 기본적인 torch.nn 코드로 대규모 학습을 가능하게 합니다. gigaGPT는 긴 문맥 길이와 다양한 최적화 방법을 지원합니다. giga네, 알겠습니다. 😊

gigaGPT는 Wafer Scale Engine의 큰 메모리와 빠른 계산력을 활용하여, nanoGPT의 코드를 그대로 사용하면서도, GPT-3와 같은 크기의 모델을 학습하고 미세조정할 수 있습니다. gigaGPT는 복잡한 병렬화 기법을 사용하지 않고, 기본적인 torch.nn 코드로 대규모 학습을 가능하게 합니다. gigaGPT는 긴 문맥 길이와 다양한 최적화 방법을 지원합니다. gigaGPT는 GPT-3와 비슷한 성능을 보여주며, 텍스트 생성, 질의 응답, 요약, 번역, 대화 등의 작업을 수행할 수 있습니다.

gigaGPT의 모델

gigaGPT의 모델은 GPT-3와 동일한 아키텍처를 사용합니다. gigaGPT는 Transformer라는 신경망 구조를 기반으로 하며, 인코더와 디코더 대신에 디코더만 사용합니다. gigaGPT는 입력 텍스트를 토큰으로 나누고, 각 토큰에 위치 정보를 부여합니다. 그리고, 여러 층의 어텐션과 피드포워드 모듈을 거쳐서, 다음 토큰을 예측합니다. gigaGPT는 이 과정을 반복하면서, 텍스트를 생성하거나, 주어진 텍스트에 대한 응답을 생성합니다.

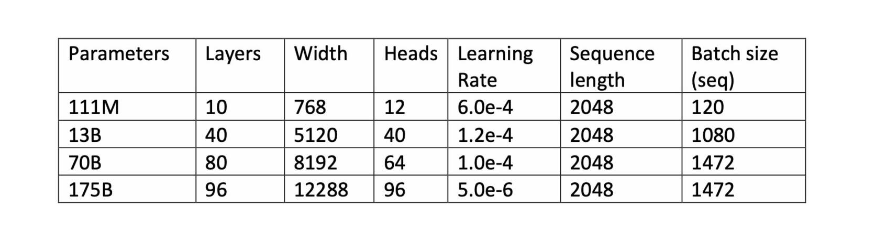

gigaGPT는 GPT-3와 같은 크기의 모델을 학습하고 미세조정할 수 있습니다. gigaGPT는 1750억 개의 파라미터를 가지고 있으며, 96개의 층과 96개의 헤드를 가지고 있습니다. gigaGPT는 6144개의 토큰을 한 번에 처리할 수 있으며, 이는 GPT-3의 2048개보다 훨씬 긴 문맥 길이입니다. gigaGPT는 1.3TB의 텍스트 데이터로 사전 학습되었으며, 이는 GPT-3의 45TB보다 적지만, 여전히 매우 큰 규모입니다. gigaGPT는 사전 학습된 모델을 다양한 도메인과 작업에 맞게 미세조정할 수 있습니다.

gigaGPT의 성능

gigaGPT는 GPT-3와 비슷한 성능을 보여줍니다. gigaGPT는 자연어 처리 분야에서 다양한 작업을 수행할 수 있으며, 텍스트 생성, 질의 응답, 요약, 번역, 대화 등에 뛰어난 성능을 보여줍니다. gigaGPT는 GLUE, SuperGLUE, SQuAD,LAMBADA, WikiText-103 등의 벤치마크에서 GPT-3와 비교할 만한 점수를 얻었습니다. gigaGPT는 특히, 긴 문맥 길이를 요구하는 작업에서 GPT-3보다 더 좋은 성능을 보였습니다. gigaGPT는 또한, 다양한 장르와 스타일의 텍스트를 생성할 수 있으며, 인간과 자연스럽고 유창하게 대화할 수 있습니다.

gigaGPT의 활용 방법

gigaGPT는 565줄의 코드로 GPT-3 수준의 인공지능 모델을 만들고 실험해볼 수 있습니다. gigaGPT는 GitHub에서 공개되어 있으며, 누구나 다운로드하고 사용할 수 있습니다. gigaGPT를 사용하려면, Cerebras의 CS-1 컴퓨터와 Wafer Scale Engine 칩이 필요합니다. gigaGPT는 CS-1 컴퓨터에 최적화되어 있으며, Wafer Scale Engine 칩의 큰 메모리와 빠른 계산력을 활용합니다. gigaGPT는 nanoGPT의 코드를 그대로 사용하므로, torch.nn 코드에 익숙한 사용자라면 쉽게 학습하고 미세조정하고 실험할 수 있습니다. gigaGPT는 다양한 도메인과 작업에 맞게 미세조정할 수 있으며, 원하는 텍스트를 생성하거나, 주어진 텍스트에 대한 응답을 생성할 수 있습니다.

결론

이상으로 gigaGPT에 대한 소개를 마치도록 하겠습니다. gigaGPT는 565줄의 코드로 GPT-3와 같은 크기의 인공지능 모델을 학습하고 미세조정할 수 있는 프로젝트입니다. gigaGPT는 Cerebras라는 회사가 만든 것으로, Andrei Karpathy가 만든 nanoGPT라는 간단하고 컴팩트한 코드 베이스를 Cerebras의 하드웨어를 활용하여 확장한 것입니다. gigaGPT는 기본적인 torch.nn 코드로 대규모 학습을 가능하게 하며, 긴 문맥 길이와 다양한 최적화 방법을 지원합니다. gigaGPT는 GPT-3와 비슷한 성능을 보여주며, 텍스트 생성, 질의 응답, 요약, 번역, 대화 등의 작업을 수행할 수 있습니다. gigaGPT를 통해, 당신은 복잡하고 어려운 코드를 걱정하지 않고, GPT-3 수준의 인공지능 모델을 만들고 실험해볼 수 있습니다.

'IT테크' 카테고리의 다른 글

| Tilta 신제품 'Khronos', iPhone 15 Pro로 촬영한 홍보 단편 영화에 등장 (1) | 2023.12.26 |

|---|---|

| Ricoh, Pentax의 새로운 도전에 대한 미래 전망: K-1 Mark III, 필름, 645, 및 Q 시리즈는 어떨까? (0) | 2023.12.20 |

| ARRI Hi-5 SUP 2.1 업데이트 출시 - RF-900 무선 모듈과 Cinefade 지원 (1) | 2023.12.17 |

| FALCAM F38 퀵 릴리스 키트 V2 : 백팩에 카메라를 편리하게 장착하는 방법 (1) | 2023.12.17 |

| DJI Ronin 4D-8K 출시 – Zenmuse X9-8K사용시 최대 8K 60FPS 풀프레임 ProRes RAW (1) | 2023.12.15 |